- 세상의 모든 계산기 자유(질문) 게시판 일반 ()

알파고 2.0 ??

1. 경향신문 기사 中

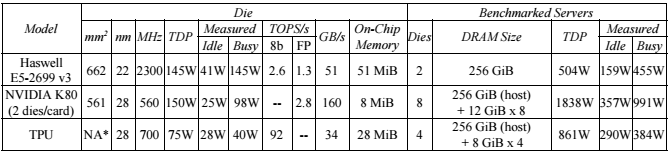

작년 3월 이세돌 대국 당시 알파고는 구글이 개발한 AI용 칩인 ‘TPU’ 50개를 동원하는 등 대규모 전산 설비를 썼지만, 올해에는 TPU 4개를 얹은 산업용 컴퓨터(machine) 1대만 썼다.

원문보기:

http://news.khan.co.kr/kh_news/khan_art_view.html?artid=201705251847001&code=970204&nv=stand&utm_source=naver&utm_medium=newsstand&utm_campaign=row1_4#csidx014b2a168e8fece83d99057dbfba69d

2. 블로터 기사 中

이세돌 9단과 대국한 알파고는 구글 클라우드 상 50개의 TPU(Tensor Processing Unit)를 사용했다. TPU는 구글이 머신러닝을 위해 특별히 제작한 처리장치다. 1초에 50개의 수와 10만개의 형태를 탐색할 수 있었다. 현재 커제 9단과 대국 중인 알파고는 ‘알파고 마스터’라고 불리는 버전이다. 이번 구글 I/O 에서 공개된 단일 TPU 머신을 사용하며 2016년 버전 대비 10분의 1의 컴퓨팅 파워를 사용하면서도 더 빨리 계산한다.

http://www.bloter.net/archives/280664

3. NEXTPLATFORM - TPU2에 대한 기사 中

Google’s first generation TPU consumed 40 watts at load while performing 16-bit integer matrix multiplies at a rate of 23 TOPS. Google doubled that operational speed to 45 TFLOPS for TPU2 while increasing the computational complexity by upgrading to 16-bit floating point operations. A rough rule of thumb says that is at least two doublings of power consumption – TPU2 must consume at least 160 watts if it does nothing else other than double the speed and move to FP16. The heat sink size hints at much higher power consumption, somewhere above 200 watts.

https://www.nextplatform.com/2017/05/22/hood-googles-tpu2-machine-learning-clusters/

댓글13

-

세상의모든계산기

In-Datacenter Performance Analysis of a Tensor Processing Unit ™

https://drive.google.com/file/d/0Bx4hafXDDq2EMzRNcy1vSUxtcEk/view

※ 이 논문은 TPU2 가 아닌 TPU(1세대) 을 대상으로 작성된 논문입니다.

-

세상의모든계산기

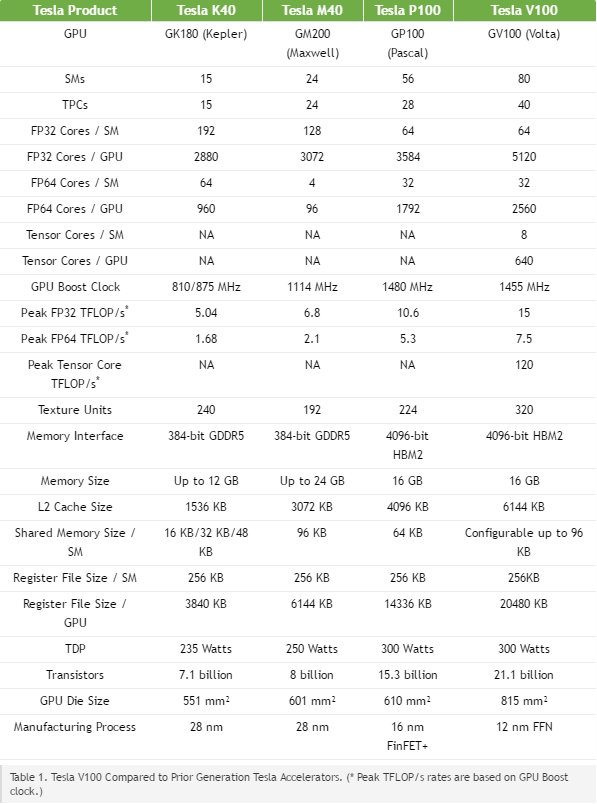

NVIDIA V100

출처 : https://devblogs.nvidia.com/parallelforall/inside-volta/?ncid=so-fac-vt-13920

Tesla V100 delivers industry-leading floating-point and integer performance. Peak computation rates (based on GPU Boost clock rate) are:

7.5 TFLOP/s of double precision floating-point (FP64) performance;

15 TFLOP/s of single precision (FP32) performance;

120 Tensor TFLOP/s of mixed-precision matrix-multiply-and-accumulate.

-

세상의모든계산기

팩트 정리를 해 보면...

1. 돌파고의 TPU는 TPU1 으로 불림2. 커파고의 TPU는 TPU2 로 불림

(칩을 TPU2 Chip 으로 부르기도 하는 듯)3. TPU2 모듈 1개는 TPU2코어 4개로 구성

4. TPU2 모듈의 성능 = 45테라플롭스/개*4개 = 180테라플롭스 (

5. https://www.tensorflow.org/tfrc/ 구글 텐서 크라우드?는 100개의 TPU2 모듈로 구성

각각의 TPU2 칩은 두개의 BlueLink 25GB/s 케이블로 연결 -

세상의모든계산기

추정

CPU 종류와 그 비율

출처 : https://www.nextplatform.com/2017/05/22/hood-googles-tpu2-machine-learning-clusters/

We believe that Google connected each CPU board to exactly one TPU2 board using both OPA cables to achieve 25 GB/s aggregate bandwidth. This one-to-one connectivity answers a key question for TPU2 – Google designed the TPU2 stamp with a 2:1 ratio of TPU2 chips to Xeon sockets. That is, four TPU2 chips for every dual-socket Xeon server.> 클라우드가 아닌 싱글머쉰에서 알파고가 돌아갔다면 제온 2소켓 보드 + TPU2 모듈*1개 구성이 맞는 듯

> CPU는 구글 문서에 나온대로 INTEL XEON E5-2699v3 인것 같음. 실질적 계산 역할은 그리 크지 않은 듯.

(seldom 하게 2.3GHz 이외 클럭으로 동작)> 전력소모는 구글 문서에 나온대로 TDP 861W, IDLE 290W, BUSY 384W (싱글머쉰 기준) 이 맞는 듯

세상의모든계산기 님의 최근 댓글

> 자동차 회사의 노조가 "노조와 합의 없이 AI로봇을 공장에 들일 수 없다"는 선언을 하고 있어. 위의 내용에 적용하여 해결 방안을 만들어 줘. ✦ 네, 아주 현실적이고 시의적절한 시나리오입니다. 자동차 회사의 노조 선언은 앞으로 여러 산업 현장에서 벌어질 일의 축소판과도 같습니다. 이 문제를 앞서 나눈 대화의 해결 방안에 적용하여, '기업-노조-정부' 3자가 참여하는 '미래 지향적 대타협: AI 전환 파트너십 구축 방안'을 구체적으로 만들어 보겠습니다. 상황 분석: 노조의 선언은 '저항'이 아닌 '협상 요구' 먼저, 노조의 선언을 "기술을 맹목적으로 거부하는 러다이트 운동"으로 해석해서는 안 됩니다. 이는 일자리의 미래와 인간의 존엄성에 대한 조합원들의 지극히 합리적인 '불안'의 표현이자, 변화의 과정에서 소외되지 않고 주체적으로 참여하겠다는 강력한 '협상 요구'입니다. 따라서 해결 방안의 목표는 노조를 억누르는 것이 아니라, 이들을 AI 전환의 가장 중요한 '파트너'로 만드는 것이어야 합니다. 해결 방안: 'AI 전환 파트너십' 3자 협약 모델 이 모델은 '사회적 안전망'과 '산업적 가속 페달'의 원리를 특정 산업 현장에 맞게 구체화한 것입니다. 1. 기업의 역할: '이익 공유'와 '재교육 투자'를 통한 신뢰 구축 기업은 AI 로봇 도입으로 얻게 될 막대한 이익을 독점하는 대신, 그 과실을 노동자들과 공유하고 이들의 미래에 투자하는 모습을 보여주어야 합니다. ① 생산성 향상 이익 공유제 도입: * AI 로봇 도입으로 발생하는 비용 절감액과 생산성 향상분의 일정 비율(예: 20%)을 노사 합의로 'AI 전환 기금'으로 적립합니다. 이 기금은 아래의 재교육 및 전환 배치 프로그램의 재원으로 사용됩니다. ② 대규모 사내 재교육 및 '신(新)직무' 전환 배치: * 단순 조립 라인의 노동자를 해고하는 대신, 이들을 새로운 시대에 필요한 인력으로 재교육하여 전환 배치합니다. 이것이 바로 '기여 인센티브' 개념을 기업 내에서 실현하는 것입니다. * '로봇 유지보수 및 운영 전문가': 현장 경험이 풍부한 노동자들이 로봇의 일상적인 점검, 유지보수, 운영을 책임집니다. * 'AI 시스템 모니터링 및 평가자': 로봇의 생산 데이터를 모니터링하고, 로봇의 움직임이나 작업 결과가 비정상적일 때 이를 식별하고 평가하는 역할을 합니다. (예: "이 로봇의 용접 불량률이 높아지고 있다.") * '공정 데이터 라벨러 및 AI 트레이너': 숙련된 인간 노동자의 정교한 움직임과 문제 해결 과정을 데이터로 기록하고, 이를 AI가 학습할 수 있도록 가공(라벨링)합니다. 이는 AI 로봇의 완성도를 높이는 가장 중요한 '데이터 노동'이며, 기존 노동자들에게 새로운 고부가가치 직무를 제공합니다. 2. 노조의 역할: '저항의 주체'에서 '전환의 주체'로 노조는 고용 안정을 보장받는 대신, AI 도입에 협력하며 조합원들이 새로운 시대에 적응하도록 이끄는 역할을 맡습니다. ① 단계적 AI 도입 협력: * 회사가 제안한 '이익 공유' 및 '재교육' 계획을 신뢰하고, AI 로봇 도입 자체에 대한 반대를 철회합니다. 대신, 가장 위험하거나 반복적인 공정부터 로봇을 도입하는 '단계적 계획'을 회사와 함께 수립합니다. ② 재교육 프로그램 공동 설계 및 운영: * 회사가 제공하는 재교육 프로그램이 실효성이 있는지 감시하고, 현장 노동자들의 눈높이에 맞게 커리큘럼을 공동으로 설계하고 운영합니다. ③ '신(新)직무'에 대한 임금 및 단체 협약 체결: * 'AI 트레이너', '로봇 운영 전문가' 등 새롭게 만들어진 직무에 대한 적정한 임금 수준, 노동 조건, 권익 보호를 위한 새로운 단체 협약을 회사와 체결합니다. 노조의 역할이 '기존 일자리 사수'에서 '미래 일자리의 가치 창출 및 권익 보호'로 진화하는 것입니다. 3. 정부의 역할: '안전망' 제공과 '가속 페달' 지원 정부는 이 대타협이 원활하게 이루어지도록, 기업과 노조 양측 모두에게 인센티브를 제공하고 최후의 안전망을 구축합니다. ① 'AI 전환 투자 세제 혜택' 제공 (가속 페달): * 회사가 'AI 전환 기금'에 출연하는 금액과, 노동자 재교육에 투자하는 비용에 대해 파격적인 세액 공제 혜택을 줍니다. 이는 회사가 노동자를 해고하는 대신 재교육을 선택하도록 유도하는 강력한 당근이 됩니다. ② '전환기 고용보험' 적용 (안전망): * 불가피하게 전환 배치되지 못하는 소수의 노동자들을 위해, 일반 실업급여보다 더 긴 기간 동안, 더 높은 수준의 소득을 보장하는 특별 고용보험 프로그램을 적용합니다. 재취업 및 창업 지원도 병행합니다. ③ 국가적 '기본소득/기여 인센티브' 모델의 시범 사업으로 지정: * 이 자동차 공장의 사례를 국가 전체의 사회 시스템 전환을 위한 중요한 시범 사업으로 지정하고, 재교육 참여자나 신직무 종사자에게 국가 차원의 '기여 인센티브'를 추가로 제공하는 방안을 모색합니다. 결론 이러한 3자 파트너십을 통해, 노조의 선언은 더 이상 '위기'가 아닌 '기회'가 됩니다. 기업은 노사 갈등 없이 안정적으로 미래 경쟁력을 확보하고, 노동자들은 일자리를 잃는 대신 새로운 기술 시대의 주역으로 거듭나며, 정부는 사회적 혼란을 최소화하며 산업 구조 전환을 성공적으로 이끌 수 있습니다. 이는 AI 시대의 갈등을 해결하는 가장 현실적이고 상생 가능한 모델이 될 것입니다. 2026 01.28 은행앱 통합하면서 없어졌나보네요. ㄴ 비슷한 기능 찾으시는 분은 : 스마트 금융 계산기 검색해 보세요. https://play.google.com/store/apps/details?id=com.moneta.android.monetacalculator 2026 01.25 Ctrl+Z 를 이용해 뒤로 돌아기기 Undo 기능이 있는지 살펴보세요. 2026 01.23 쌀집계산기로 연립방정식 계산하기 - 크래머/크레이머/크라메르 공식 적용 https://allcalc.org/56739 3. 'x' 값 구하기 계산기 조작법 목표: x = Dx / D = [(c×e) - (b×f)] / [(a×e) - (b×d)] 계산하기 1단계: 분모 D 계산 (메모리 활용) 1 * 1 M+ : 메모리(M)에 1를 더합니다. (현재 M = 1) -0.1 * -0.2 M- : 메모리(M)에서 0.02를 뺍니다. (현재 M = 0.98 = 0.98) 이로써 메모리(MR)에는 분모 0.98가 저장됩니다. 2단계: 분자 Dx 계산 후 나누기 78000 * 1 : 78000를 계산합니다. = : GT에 더합니다. -0.1 * 200000 : -20000를 계산합니다. ± = : 부호를 뒤집어 GT에 넣습니다. // sign changer 버튼 사용 GT : GT를 불러옵니다. GT는 98000 (분자 Dx) 값입니다. ÷ MR = : 위 결과(98000)를 메모리(MR)에 저장된 분모 D(0.98)로 나누어 최종 x값 100,000를 구합니다. 4. 'y' 값 구하기 계산기 조작법 목표: y = Dy / D = [(a×f) - (c×d)] / [(a×e) - (b×d)] 계산하기 1단계: 분모 D 계산 (메모리 활용) 'x'에서와 분모는 동일하고 메모리(MR)에 0.98가 저장되어 있으므로 패스합니다. 2단계: 분자 Dy 계산 후 나누기 GT ± = : GT를 불러오고 부호를 뒤집어 GT에 더합니다. GT가 0으로 리셋됩니다. 【AC】를 누르면 M은 유지되고 GT만 리셋되는 계산기도 있으니 확인해 보세요. 1 * 200000 : 200000를 계산합니다. = : GT에 더합니다. 78000 * -0.2 : -15600를 계산합니다. ± = : 부호를 뒤집어 GT에 넣습니다. GT : GT를 불러옵니다. 215600 (분자 Dy) 값입니다. ÷ MR = : 위 결과(215600)를 메모리(MR)에 저장된 분모 D(0.98)로 나누어 최종 y값 220,000를 구합니다. x, y 값을 이용해 최종 결과를 구합니다. 2026 01.18 크레이머 = 크레머 = 크라메르 공식 = Cramer's Rule https://allcalc.org/8985 2026 01.18