- 세상의 모든 계산기 자유(질문) 게시판 일반 ()

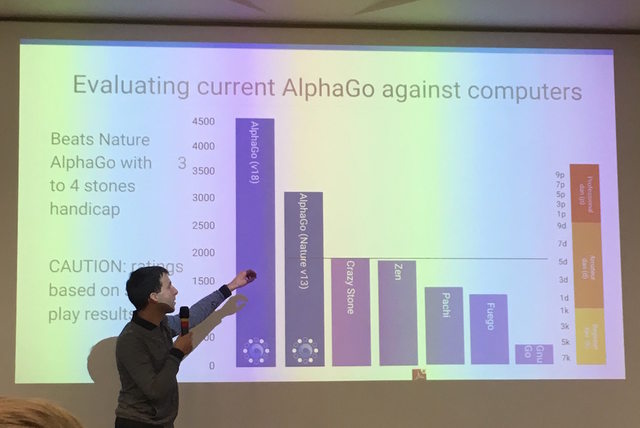

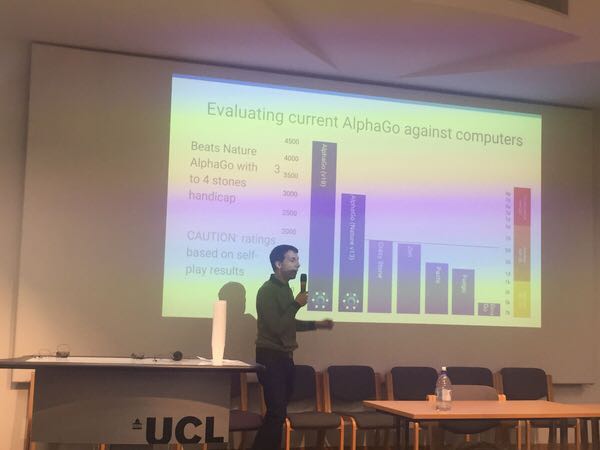

알파고 ELO Rating 이 4500??

사진 출처 :

http://test.pgr21.com/pb/pb.php?id=humor&no=269200

http://gall.dcinside.com/board/view/?id=baduk&no=137040&page=5

http://www.lifein19x19.com/forum/viewtopic.php?f=18&t=12922

https://www.zhihu.com/question/41780229

David Silver yesterday gave a lecture at UCL, which refers to the ELO ratings AlphaGo, where chess with Shishi version (v18) actually has up to 4500 points, allowing the arm with Fan chess that paragraph AlphaGo (v13) four sub . ELO rating is the score http://goratings.org on the current world chess Ke Jie was the first person to 3615 points - the points difference Elo rating represents the corresponding winning percentage, 800 points, then the difference between winning percentage is 100%, the difference between 677 if winning is 99%. Shishi learned this after watching scores of the fourth set, with no set up (?) Cherish the AlphaGo labeled bug state, is really not easy.

중국어 -> 영어 구글 번역

- Nature v13 = 판후이와 대국했던 시절(네이쳐 논문발표) 버전의 알파고

- v18 = 이세돌과 대국한 버전의 알파고 (하드웨어 동일?)

- v18 의 기력 측정은 Nature v13 과 4점 접바둑을 통해 측정한 기력

댓글6

-

세상의모든계산기

출처 : http://www.bbsdigest.com/thread/index?bid=87&tid=31270999

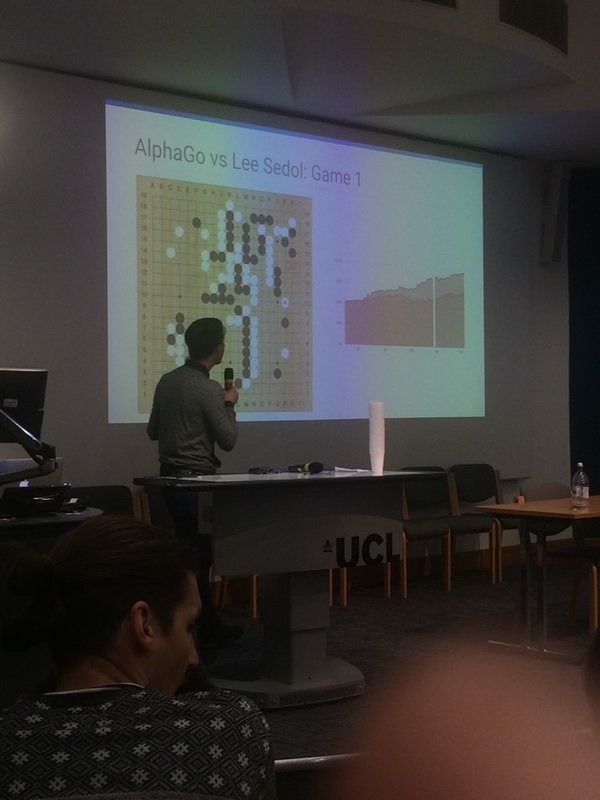

I'm a PhD student in Computational Neuroscience/Machine Learning who attended a talk today at UCL by David Silver, lead author on the AlphaGo Nature paper: http://www.nature.com/nature/journal/v529/n7587/full/nature16961.html Although unfortunately I didn't take any pictures, I can confirm he did show us some slides on AlphaGo's evaluation functions and how their assessment of the probability of winning changed during the course of each match.

Since I heard there was some interest about whether the game is balanced in its initial state, I looked carefully at the initial intersection with the y-axis, corresponding to the point at which no moves had been played. I can confirm that according to the Value Network's assessment, white has an initial probability of winning bigger that 50%, my guess being 53% (the scale used a 25% interval and so was very hard to read). By contrast, the Monte Carlo rollout had what looked like an almost exact 50-50 assessment. Although AlphaGo uses both assessments, David Silver said that the Value Network is in general more accurate and is thus more highly weighted in the latest versions of AlphaGo. So it's fair to say AlphaGo thinks white (with 7.5 komi) has a small advantage.

Also, one other interesting tidbit is that according to Deepmind's internal assessment, AlphaGo's ELO was much, much bigger than Lee Sedol's (above 4000 iirc). However, David Silver acknowledged that he didn't really trust their internal assessment as AlphaGo was only playing versions of itself by reinforcement learning, and so may have been completely unaware of surprising strategies which can beat it. Which is why they had to play Lee Sedol in those exciting matches (and indeed, according to their internal ELO they probably would have expected 5-0 not 4-1)

Hope you find this interesting anyway, I sure did!요약

- 알파고 가치망에서는 덤7.5집일 때 백이 약간이나마 유리하다고 평가

- 알파고 ELO 4500 은 간접측정이라 신뢰성이 부족.

-

세상의모든계산기

구글 번역 사이트가 인공신경 지능망으로 업그레이드 되었다고 합니다. (2016-11-16)

그래서 위의 영문을 번역시켜 보았습니다.저는 Computational Neuroscience / Machine Learning의 박사 과정 학생으로서 AlphaGo Nature 논문의 수석 저자 David Silver가 UCL에서 오늘 연설을했습니다 : http://www.nature.com/nature/journal/v529/n7587/full /nature16961.html 불행히도 사진을 찍지는 않았지만 AlphaGo의 평가 기능에 대한 슬라이드와 각 경기가 진행되는 동안 우승 확률에 대한 평가가 어떻게 달라지는 지 확인할 수있었습니다.

게임이 초기 상태에서 균형을 이루는 지에 대한 관심이 있다고 들었으므로 움직이지 않는 지점에 해당하는 y 축과의 초기 교차점을주의 깊게 살펴 봤습니다. Value Network의 평가에 따르면 흰색은 초기 확률이 50 % 이상인 것으로 나타났습니다. 내 생각에 53 % (25 %의 눈금을 사용했기 때문에 읽는 것이 매우 어려웠습니다)입니다. 대조적으로, 몬테카를로 롤아웃은 거의 정확한 50-50 평가처럼 보였습니다. AlphaGo는 두 가지 평가를 모두 사용하지만 David Silver는 Value Network가 일반적으로 정확하고 AlphaGo의 최신 버전에 더 가중되어 있다고 말했습니다. 그래서 AlphaGo는 흰색 (7.5 komi)이 작은 이점을 가지고 있다고 생각한다고 말하는 것은 공평합니다.

또한, 흥미로운 또 하나의 재미있는 점은 Deepmind의 내부 평가에 따르면 AlphaGo의 ELO가 Lee Sedol (4000 iirc 이상)보다 훨씬 크다는 것입니다. 그러나 David Silver는 AlphaGo가 강화 학습을 통해 버전을 재생하기 때문에 내부 평가를 실제로 신뢰하지 않았기 때문에이를 극복 할 수있는 놀라운 전략을 전혀 알지 못했을 수도 있음을 인정했습니다. 그래서 그들이 흥미 진진한 경기에서 Lee Sedol과 경기를해야했던 이유입니다. (실제로 내부 ELO에 따르면 그들은 아마도 5-0에서 4-1로 예상했을 것입니다)

어쨌든이 재미있는 것을 찾으시기 바랍니다.와우... 인상적이네요.

-

세상의모든계산기

참고 : 한국기원 기사 랭킹제도

https://www.baduk.or.kr/record/ranking_info.asp- 승률 기대치 = E(d) =

- 조정되는 점수 =

K=16,

α=0.8=패자에게만 주어지는 위로점수? (디플레이션 방지 목적)

* 가중치

예선 본선 결승전(도전기) 1등급 기전 1.5 2.3 3.0 2등급 기전 1.3 1.9 2.5 3등급 기전 1.0 1.5 2.0 제한 기전 및 특별 대국 1.0 1.0 1.5 * 임시점수 : 대국 숫자가 적은 선수는 임시점수제도를 통해 점수 부여

-

세상의모든계산기

절예 // 가중치 개선 진행중?

카타고 (18*384nbt) // 가중치 개선 진행중

카타고 (60*320)

카타고 (40*384)

카타고 (40*256)

카타고 (30*256)

카타고 (20*256)

알파고 제로 (40*256, 40일)

릴라 제로 #272 (40*256)

미니고 v17 (20*256)

미니고 v16 (40*256)

알파 제로 (20*256, 36시간)

엘프고 v2 (20*256)

알파고 제로 (20b, 3일)

알파고 마스터

인간 프로 기사 GOAT

알파고 리 (=인간 프로 기사 최상급)

인간 프로 기사 현역

알파고 판

기준 : 블럭*채널, 가장 강한 가중치 버전

직접 대국하지 않은 것이 많아 추정일 뿐임.

https://www.reddit.com/r/baduk/comments/hma3nx/unified_elo_rating_for_ais/

위 글을 기본으로 작성한 순위표임. / SHKD13 작성https://github.com/breakwa11/GoAIRatings#go-ai-ratings

기본적으로는 여기서 많이 가져온 듯 하고,

알파고와 비교할 수 있는 것은 엘프고 개발자의 멘트가 중요했던 듯 싶음.

세상의모든계산기 님의 최근 댓글

fx-570 CW 는 아래 링크에서 https://allcalc.org/56026 2025 10.24 불러오기 할 때 변수값을 먼저 확인하고 싶을 때는 VARIABLE 버튼 【⇄[x]】목록에서 확인하고 Recall 하시면 되고, 변수값을 이미 알고 있을 때는 바로 【⬆️SHIFT】【4】로 (A)를 바로 입력할 수 있습니다. 2025 10.24 fx-570 CW 로 계산하면? - 최종 확인된 결과 값 = 73.049507058478629343538 (23-digits) - 오차 = 6.632809104889414877 × 10^-19 꽤 정밀하게 나온건 맞는데, 시뮬레이션상의 22-digits 와 오차 수준이 비슷함. 왜 그런지는 모르겠음. - 계산기중 정밀도가 높은 편인 HP Prime CAS모드와 비교해도 월등한 정밀도 값을 가짐. 2025 10.24 HP Prime 에서 <Home> 73.0495070344 (12-decimal-digits) // python 시뮬레이션과 일치 <CAS> 21자리까지 나와서 이상하다 싶었는데, Ans- 에서 자릿수를 더 늘려서 빼보니, 뒷부분 숫자가 아예 바뀌어버림. 버그인가? (전) 73.0495070584718691243 (21-digits ????) (후) 73.0495070584718500814401 (24-digits ????) 찾아보니 버그는 아니고, CAS에서는 십진수가 아니라 2진수(bit) 단위로 처리한다고 함. Giac uses 48 bits mantissa from the 53 bits from IEEE double. The reason is that Giac stores CAS data (gen type) in 64 bits and 5 bits are used for the data type (24 types are available). We therefore loose 5 bits (the 5 low bits are reset to 0 when a double is retrieved from a gen). 출처 : https://www.hpmuseum.org/cgi-bin/archv021.cgi?read=255657 일단 오차를 놓고 보면 16-decimal-digits 수준으로 보임. 2025 10.23 khiCAS 에서 HP 39gII 에 올린 khiCAS는 254! 까지 계산 가능, 255! 부터는 ∞ fx-9750GIII 에 올린 khiCAS는 factorial(533) => 425760136423128437▷ // 정답, 10진수 1224자리 factorial(534) => Object too large 2025 10.23