- 세상의 모든 계산기 자유(질문) 게시판 일반 ()

구글 Cloud TPU v3

1. TPU v3

3세대 프로세서(processor)는 2세대(v2)에 비해 2배 빨라짐.

pod 당 칩 개수는 4배 증가. pod 단위로 비교하면 8배(=2*4) 빨라짐.

https://en.wikipedia.org/wiki/Tensor_processing_unit

ㄴ 1년마다 버전 업?

2. Pod ? Board(X)

Board는 TPU 프로세서가 박힌 기판(1. 사진참고)

Shelf 는 사진상 하나의 층이라고 보면 될 듯

Rack 은 Shelves 의 묶음 (프레임, 전원, 쿨러 등 포함)

ㄴ V3(우)는 수냉식 채용(아래 저것은 물통인가? 펌프인가?)

Pod는 Rack 의 묶음

ㄴ 상단(v2 pod=4 Racks) 하단(Cloud TPUv3 pod=8 Racks)

이상 사진 출처 : https://www.nextplatform.com/2018/05/10/tearing-apart-googles-tpu-3-0-ai-coprocessor/

3. 가격은?

| 기본 | 선점형 | |

| 단일 TPU v2 | 4.5$/(1TPU*시간) | 1.35$/(1TPU*시간) |

| 단일 TPU v3(베타) | 8$/(1TPU*시간) | 2.4$/(1TPU*시간) |

| TPU v2*32 | 24$/(슬라이스*시간) | |

| TPU v2*512 | 384$/(슬라이스*시간) |

* 출처 : https://cloud.google.com/tpu/docs/pricing?hl=ko

* 선점형 : 문구는 더 강력할 것 같지만 반대인 건가? Cloud TPU가 다른 작업을 위해 리소스에 액세스할 경우 언제든지 종료(선점)할 수 있는 TPU. (할당량은 선점형이 더 많긴 한데...)

* VM instance 가격은 별도임.

* 1초 단위로 청구

댓글2

-

세상의모든계산기

Edge TPU

구글은 TPU 를 클라우드 뿐 아니라, 개별 단말에서도 사용할 수 있도록 유닛화하여 판매할 계획인 듯.

명칭은 엣지 TPU.

https://cloud.google.com/edge-tpu/

단말이라고 하지만 PC를 위한 것은 아닌 것 같고 IoT 기기를 위한 것으로 보임.

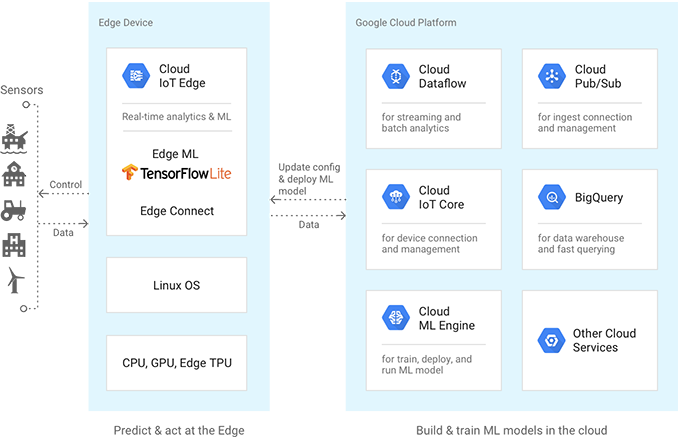

데이터 학습등은 cloud에서 하고, 실시간 적용은 말단에서?Edge(Devices/nodes, Gateways, Servers)Google Cloud Tasks ML inference ML training and inference Software, services Cloud IoT Edge, Linux OS Cloud ML Engine, Kubernetes Engine, Compute Engine, Cloud IoT CoreML frameworks TensorFlow Lite, NN API TensorFlow, scikit-learn,XGBoost, KerasHardware accelerators Edge TPU, GPU, CPU Cloud TPU, GPU, and CPU Edge TPU features

This ASIC is the first step in a roadmap that will leverage Google's AI expertise to follow and reflect in hardware the rapid evolution of AI.

Type Inference Accelerator Performance Example Edge TPU enables users to concurrently execute multiple state-of-the-art AI models per frame, on a high-resolution video, at 30 frames per second, in a power-efficient manner. Numerics Int8, Int16 IO Interface PCIe, USB

세상의모든계산기 님의 최근 댓글

엑셀 파일로 만드니 전체 160~200MB 정도 나옵니다. 읽고 / 저장하는데 한참 걸리네요. 컴 사양을 좀 탈 것 같습니다. -> 엑셀/한셀에서 읽히지만, 구글 스프레드시트에서는 열리지 않네요. 100만 개 단위로 끊어서 20MB 정도로 분할해 저장하는 편이 오히려 속 편할 것 같습니다. -> 이건 구글 스프레드시트에서도 열리긴 하네요. (약간 버퍼링?이 있습니다) 2026 02.10 엑셀 / 행의 최대 개수, 열의 최대 개수, 셀의 최대 개수 엑셀의 행 개수 제한은 파일 형식에 따라 다르며, 최신 .xlsx 파일 형식은 시트당 최대 1,048,576행까지 지원하지만, 구형 .xls 파일은 65,536행으로 제한됩니다. 따라서 대용량 데이터를 다룰 때는 반드시 최신 파일 형식(.)으로 저장해야 하며, 행과 열의 총 수는 1,048,576행 x 16,384열이 최대입니다. 주요 행 개수 제한 사항: 최신 파일 형식 (.xlsx, .xlsm, .xlsb 등): 시트당 1,048,576행 (2^20). 구형 파일 형식 (.xls): 시트당 65,536행 (2^16). 그 외 알아두면 좋은 점: 최대 행 수: 1,048,576행 (100만여개) 최대 열 수: 16,384열 (XFD) 대용량 데이터 처리: 65,536행을 초과하는 데이터를 다루려면 반드시 .xlsx 형식으로 저장하고 사용해야 합니다. 문제 해결: 데이터가 많아 엑셀이 멈추거나 오류가 발생하면, 불필요한 빈 행을 정리하거나 Inquire 추가 기능을 활용하여 파일을 최적화할 수 있습니다. 2026 02.10 [일반계산기] 매출액 / 원가 / 마진율(=이익율)의 계산. https://allcalc.org/20806 2026 02.08 V2 갱신 (nonK / K-Type 통합형) 예전에는 직접 코드작성 + AI 보조 하여 프로그램 만들었었는데, 갈수록 복잡해져서 손 놓고 있었습니다. 이번에 antigravity 설치하고, 테스트 겸 새로 V2를 올렸습니다. 직접 코드작성하는 일은 전혀 없었고, 바이브 코딩으로 전체 작성했습니다. "잘 했다 / 틀렸다 / 계산기와 다르다." "어떤 방향에서 코드 수정해 봐라." AI가 실물 계산기 각정 버튼의 작동 방식에 대한 정확한 이해는 없는 상태라서, V1을 바탕으로 여러차례 수정해야 했습니다만, 예전과 비교하면 일취월장 했고, 훨씬 쉬워졌습니다. 2026 02.04 A) 1*3*5*7*9 = 계산 945 B) √ 12번 누름 ㄴ 12회 해도 되고, 14회 해도 되는데, 횟수 기억해야 함. ㄴ 횟수가 너무 적으면 오차가 커짐 ㄴ 결과가 1에 매우 가까운 숫자라면 된 겁니다. 1.0016740522338 C) - 1 ÷ 5 + 1 = 1.0003348104468 D) × = 을 (n세트) 반복해 입력 ㄴ 여기서 n세트는, B에서 '루트버튼 누른 횟수' 3.9398949655688 빨간 부분 숫자에 오차 있음. (소숫점 둘째 자리 정도까지만 반올림 해서 답안 작성) 참 값 = 3.9362834270354... 2026 02.04