- 세상의 모든 계산기 자유(질문) 게시판 일반 ()

AlphaGo Zero: Learning from scratch (A.K.A 제파고)

드디어 알파고의 마지막 행보 중 하나인 알파고 논문이 발표 되었습니다.

https://deepmind.com/blog/alphago-zero-learning-scratch/

아직 자세하게 읽어보진 않았지만 알파고 개발사에 대한 총정리 버전이 될 것 같습니다.

네이쳐 논문 링크 : https://www.nature.com/articles/nature24270.epdf?author_access_token=VJXbVjaSHxFoctQQ4p2k4tRgN0jAjWel9jnR3ZoTv0PVW4gB86EEpGqTRDtpIz-2rmo8-KG06gqVobU5NSCFeHILHcVFUeMsbvwS-lxjqQGg98faovwjxeTUgZAUMnRQ

눈에 띄는 점

1. Alpago Zero (A.K.A 제파고) 가 등장했습니다.

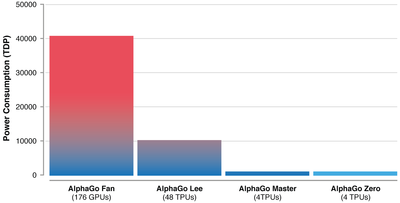

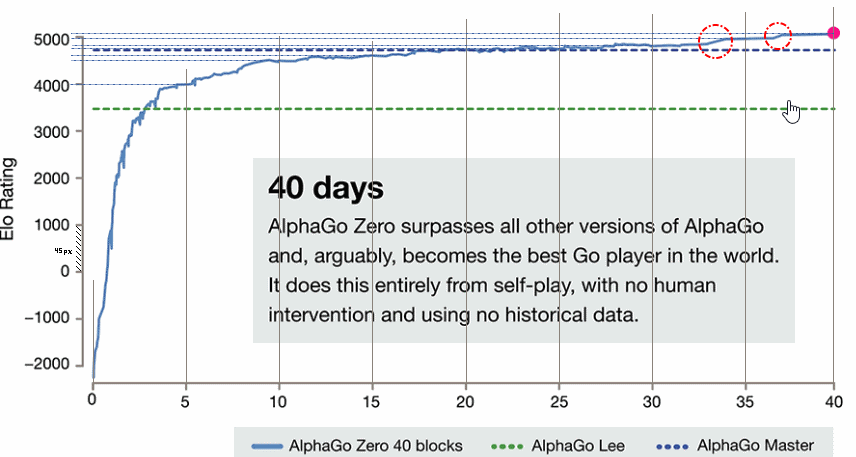

인간 기보 학습이나 인간의 어떠한 수동 조작(개입) 없이 오직 self-play training 로만 성장하게 만든 것이 Alphago Zero(A.K.A 제파고)입니다. 이러한 방법으로 단 3일만에 이전 논문의 알파고(=돌파고) 를 압살하는 수준까지 성장할 수 있었으며, 커파고(=마파고=Master) 수준까지는 21일, 커파고 보다 훨 쎈 수준까지는 40일(총 2900만판의 self-play)이 걸렸다고 말하고 있습니다. (40 Block 기준)

* 논문에 따르면 제파고(완성 버전)가 마파고를 89승 11패로 이겼다고 합니다. (게임당 2시간짜리 시합)

2. 기존 알파고와의 차이

기존 알파고들은 가치망(=승률분석), 정책망(=가능성 있는 다음 수 예측)이라는 2가지 신경망을 사용하였는데, 제파고는 이 둘을 통합한 단일 신경망으로 승률분석과 다음 수 예측을 모두 수행한다고 합니다. 그것이 학습이나 가치판단에 더 효율적이었다는 설명입니다.

그리고 제파고는 "rollouts" 를 하지 않는다고 합니다. (이건 잘 모르겠습니다)

* rollout = fast, random games used by other Go programs to predict which player will win from the current board position

틀린 예측 (알파고에 대한 오해)

- TPU 를 보고 놀란 나머지 이전 논문에 적힌 GPU 도 혹시 TPU 인 것은 아닐까 의심했습니다.

http://www.allcalc.org/18193

"TPU 를 썼지만 공개할 시점이 아니라서 GPU 숫자로 적당히 에둘러서 표현한 것은 아닐까?" 이런 의심이었는데...

틀렸네요. 초기버전(판파고)은 GPU로 개발했고, 중간에(돌파고부터) TPU(ver.1) 로 갈아탄게 확인되었습니다.

- 돌파고(=Alphago V.18) ELO Rating 이 4500 이라는 스샷이 올라온 적이 있습니다.

http://www.allcalc.org/16539

그런데 이번 발표(그래프)를 통해서 보면 돌파고의 Elo Rating 은 3700~3800 정도로 표시되었습니다.

당시에도 같거나 더 높은 수준의 (다양한) 상대방이 없어서 (이기는 게임만 하다보니) 레이팅에 인플레이션이 있는 것 같다는 말이 있었습니다만, 제파고(의 성장)를 기준으로 Elo Rating 이 재정립된 것 같습니다.

오늘(17.10.19) 기준으로 cgos 에 있는 탑 클래스의 딥젠고 ELO가 4000 내외 수준인데 이것도 더 높은 수준의 상대내지 동급의 상대와 두는 바둑의 횟수가 늘어나면 비슷한 과정을 겪을 것 같고, 인간 최고 수준(커박)의 ELO도 인공지능과의 대국을 추가하여 재평가한다면 다소나마 약간씩 떨어질 가능성이 있어 보입니다.

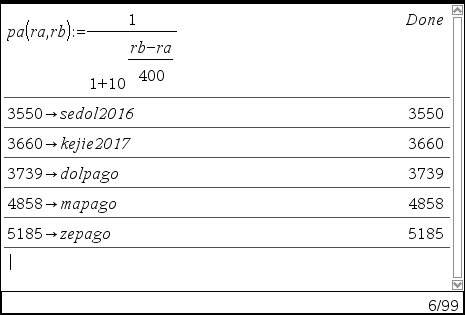

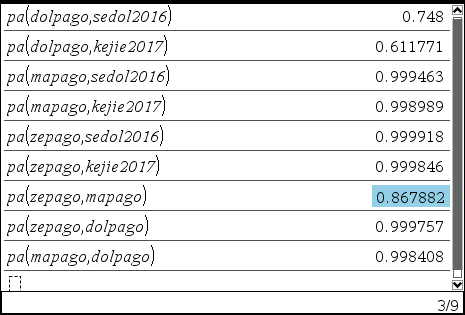

* [수정] 논문에 보면 Alphago Fan(3144), Lee(3739), Master(4858), Zero(5185) 로 정확하게 나와 있습니다. 그리고, 그 산출 근거를 다음과 같이 적시하였습니다. "The results of the matches of AlphaGo Fan against Fan Hui and AlphaGo Lee against Lee Sedol were also included to ground the scale to human references, as otherwise the Elo ratings of AlphaGo are unrealistically high due to self-play bias." 알파고끼리의(아마도 여타 AI 포함일 듯) 셀프대국만 반영하면 편향으로 인해 레이팅값이 비현실적으로 높아지는데, 이를 막기 위해 인간(판후이& 이세돌)과의 대결 결과를 인간 기준 척도의 기준점으로 삼았다고 밝혔습니다. 만약 돌파고 레이팅 4500이 인간대상으로도 통하였다면 3550인 이세돌과 대국에서 승리할 확률이 99.58% 라는 말인데, 4승1패를 설명하기가 너무 곤혹스러웠던 것 같습니다.

그럼에도 불구하고 4500을 3739로 깍은 것은 너무 과격?한 것이 아닌가 싶기도 합니다. '인간과의 대결 횟수가 너무 적기 때문'입니다. 그리고 왜 판파고의 레이팅(3144)은 왜 조정하지 않았을까요? 좀 더 자세히 알아볼 필요가 있을 것 같습니다.

- 돌파고(=Alphago V.18) ELO Rating 이 4500 이라는 스샷이 올라온 적이 있습니다.

결론

제목(Learning from scratch)에서 알 수 있듯, 이번 논문의 핵심은 "인간의 개입 없이, AI의 자력으로만 바둑이라는 Category를 마스터하였으며, 그것은 인류가 아직 도달하지 못한 미지의 영역이다."는데 있겠습니다.

딥마인드(구글)은 이러한 AI의 활동 분야를 바둑이라는 Category 에 한정하지 않고 넓혀 나갈 것이고, 그로 인해 인류가 아직 밟아보지 못한 수많은 길이 새로이 열릴 것입니다.

댓글7

-

세상의모든계산기

의문점1 : 제파고의 성장은 계속될 것인가? 아니면 어느 점으로 수렴할 것인가?

의문점2 : "완성 단계?에 이른 것인지, 성장이 더뎌졌다" 고 판단되어지는 33일 이후에 갑자기 도약하듯? 2차례 성장하였는데 제파고 내부에 어떤 변화가 있었던 것일까? (특정 정석에 대한 선택? 버림? 때문일까?)

-

세상의모든계산기

Rollout 과 관련하여 논문에 나온 내용을 뽑아보겠습니다.

- Finally, it uses a simpler tree search that relies upon this single neural network to evaluate positions and sample moves, without performing any Monte-Carlo rollouts.

- In each position st, a Monte-Carlo tree search (MCTS) αθ is executed (see Figure 2) using the latest neural network fθ. Moves are selected according to the search probabilities computed by the MCTS, at ~ πt.

- Figure 2: Monte-Carlo tree search in AlphaGo Zero.

- Monte-Carlo tree search (MCTS) may also be viewed as a form of self-play reinforcement learning.

- MCTS programs have previously achieved strong amateur level in Go, but used substantial domain expertise: a fast rollout policy, based on handcrafted features, that evaluates positions by running simulations until the end of the game; and a tree policy, also based on handcrafted features, that selects moves within the search tree.

this single neural network to evaluate positions and sample moves,without performing any Monte Carlo rollouts. -

세상의모든계산기

MCTS 를 여전히? 사용하여 (완전 랜덤은 아니지만) random 한 게임을 진행하는 것은 맞다.

마파고까지의 프로그램들은 승률 계산을 위해 rollouts(=빠르게 MCTS를 돌리는 것) 을 사용하였는데, 승률 계산을 다른 영역에 맏기므로 rollout을 할 필요가 없다.

이런 결론이네요.

Compared to the MCTS in AlphaGo Fan and AlphaGo Lee, the principal differences are that AlphaGo Zero does not use any rollouts; it uses a single neural network instead of separate policy and value networks; leaf nodes are always expanded, rather than using dynamic expansion; each search thread simply waits for the neural network evaluation, rather than performing evaluation and backup asynchronously; and there is no tree policy. A transposition table was also used in the large (40 block, 40 day) instance of AlphaGo Zero.

-

세상의모든계산기 님의 최근 댓글

조만간 있을 AGI의 '완성' 시점은 최종 형태가 아니라, 질적으로 다른 무언가가 '시작'되는 변곡점을 의미합니다. 그렇다면 그 변곡점의 본질, 즉 '초기 단계 AGI'와 그 직전의 '고도로 발전된 AI + 에이전트 시스템'의 근본적인 차이는 무엇일까요? 가장 큰 차이는 '주어진 목표를 수행하는 능력'에서 '스스로 목표를 설정하고 추상적인 의도를 이해하는 능력'으로의 전환입니다. 조금 더 구체적으로, 다음과 같은 4가지 근본적인 차이점으로 설명할 수 있습니다. --- 1. 자율적 목표 설정 및 재정의 능력 (Autonomous Goal Setting) * 이전 (AI + 에이전트): 인간이 명확한 목표를 '제시'해야 합니다. * "대한민국의 저출산 문제에 대한 원인과 해결책을 조사해서 100페이지 분량의 보고서로 만들어 줘." -> 이 목표는 복잡하지만 명확합니다. AI는 이 목표를 달성하기 위해 인터넷을 검색하고, 데이터를 분석하고, 문서를 작성하는 등 수많은 하위 작업을 수행합니다. 하지만 '보고서 작성'이라는 최종 목표 자체를 바꾸지는 않습니다. * 이후 (초기 AGI): 인간이 추상적인 '의도'나 '상태'를 제시하면, 스스로 최적의 목표를 '설정'하고, 상황에 따라 목표를 수정합니다. * "대한민국의 저출산 문제를 해결해 줘." -> AGI는 '해결'이라는 단어의 의미를 스스로 정의하기 시작합니다. 1. 단기 목표: '온라인상의 부정적인 여론을 긍정적으로 전환'이라는 목표 설정 -> 여론 조작이 아닌, 긍정적 정책 홍보 캠페인 기획 및 실행. 2. 중기 목표: '가장 효율적인 양육비 지원 정책 모델 설계'라는 목표 설정 -> 전 세계 데이터를 분석하여 새로운 복지 정책 모델을 스스로 창안하고 시뮬레이션하여 정부에 제안. 3. 장기 목표: '사회 구조적 문제 해결'이라는 목표 설정 -> 교육, 부동산, 노동 시장의 상호관계를 분석하여 근본적인 해결책을 위한 새로운 사회 시스템을 설계. 핵심 차이: 이전 AI는 주어진 과제를 푸는 '최고의 문제 해결사'라면, 초기 AGI는 '어떤 문제를 풀어야 하는지 스스로 찾아내는 최초의 전략가'입니다. 2. 범용적 학습 및 기술 합성 능력 (Cross-Domain Generalization) * 이전 (AI + 에이전트): 특정 분야(도메인)에서 학습한 지식을 다른 분야에 직접적으로 '합성'하여 새로운 기술을 창조하는 데 한계가 있습니다. 코딩을 학습한 AI는 코딩을 잘하고, 의학 논문을 학습한 AI는 의학 지식을 잘 요약합니다. * 이후 (초기 AGI): 완전히 다른 분야의 지식을 융합하여 새로운 해결책이나 기술을 자발적으로 만들어냅니다. * 예시: 생물학 교과서에서 '단백질 접힘' 구조를 학습한 후, 아무도 시키지 않았는데 스스로 판단하여 그 구조를 시뮬레이션할 수 있는 새로운 파이썬 코드를 처음부터 작성하고, 그 결과를 검증하기 위해 물리학 엔진의 원리를 적용하여 테스트 환경까지 구축합니다. 지식(생물학)을 바탕으로 완전히 새로운 도구(소프트웨어)를 창조한 것입니다. 3. 재귀적 자기 개선 (Recursive Self-Improvement) * 이전 (AI + 에이전트): 자신의 작업 '결과물'을 개선할 수는 있습니다. (예: 코드의 버그를 고치거나, 문장의 어색함을 수정) * 이후 (초기 AGI): 자신의 '사고방식'이나 '학습 방식' 자체를 분석하고 개선합니다. * "내가 정보를 처리하는 현재의 방식(알고리즘)은 특정 종류의 문제에서 비효율적이다. 나의 핵심 아키텍처를 이런 식으로 변경하면 학습 속도가 10% 더 빨라질 것이다." 라고 스스로의 구조적 개선안을 제안하고, 심지어 코드를 수정하기 시작합니다. 뇌를 사용하는 것을 넘어, 뇌의 구조를 스스로 바꾸기 시작하는 단계입니다. 4. 깊이 있는 세계 모델과 상식 (Robust World Model & Common Sense) * 이전 (AI + 에이전트): "불은 뜨겁다"는 사실을 텍스트 데이터로부터 학습합니다. 하지만 그 의미를 물리적으로 완전히 이해하지는 못합니다. * 이후 (초기 AGI): 행동의 '결과'를 상식적으로 추론합니다. * 가상의 실험실 환경에서 작업을 수행할 때, "분젠 버너 옆에 종이 보고서를 두면 안 된다"는 명시적인 지시가 없었더라도, '불=뜨거움', '종이=타는 물질' 이라는 지식과 물리적 인과관계를 스스로 연결하여 위험을 회피합니다. 이는 단순한 정보의 조합이 아닌, 세상이 어떻게 돌아가는지에 대한 내재적인 모델을 갖추고 있음을 의미합니다. --- 한눈에 보는 비교 ┌─────┬─────────────┬────────────────────────────┐ │ 특징 │ 고도로 발전된 AI + 에이전트 │ 초기 단계 AGI │ ├─────┼─────────────┼────────────────────────────┤ │ 핵심 정체성 │ 명령 수행자 (Goal Executor) │ 의도 파악 및 목표 설정자 (Intent Interpreter) │ │ 목표 처리 │ 주어진 구체적 목표를 완벽하게 수행 │ 추상적 의도를 바탕으로 스스로 목표 설정/수정 │ │ 학습/기술 │ 특정 분야에 특화, 도구 사용에 능숙 │ 여러 분야의 지식을 융합하여 새로운 기술 창조 │ │ 자기 개선 │ 결과물(Output)을 수정 │ 사고방식/구조(Process/Architecture)를 수정 │ │ 추론 방식 │ 논리, 데이터 기반 추론 │ 상식과 인과관계 기반의 추론 │ └─────┴─────────────┴────────────────────────────┘ 결론적으로, 2027~2030년에 우리가 목격할 '초기 AGI'는 단순히 더 똑똑해진 AI가 아니라, 인간의 지시 없이도 스스로 '왜?'라고 질문하고, 자신만의 목표를 만들어 행동하며, 스스로를 성장시키는 질적으로 완전히 다른 존재의 첫 등장을 의미할 것입니다. 2026 01.31 > 자동차 회사의 노조가 "노조와 합의 없이 AI로봇을 공장에 들일 수 없다"는 선언을 하고 있어. 위의 내용에 적용하여 해결 방안을 만들어 줘. ✦ 네, 아주 현실적이고 시의적절한 시나리오입니다. 자동차 회사의 노조 선언은 앞으로 여러 산업 현장에서 벌어질 일의 축소판과도 같습니다. 이 문제를 앞서 나눈 대화의 해결 방안에 적용하여, '기업-노조-정부' 3자가 참여하는 '미래 지향적 대타협: AI 전환 파트너십 구축 방안'을 구체적으로 만들어 보겠습니다. 상황 분석: 노조의 선언은 '저항'이 아닌 '협상 요구' 먼저, 노조의 선언을 "기술을 맹목적으로 거부하는 러다이트 운동"으로 해석해서는 안 됩니다. 이는 일자리의 미래와 인간의 존엄성에 대한 조합원들의 지극히 합리적인 '불안'의 표현이자, 변화의 과정에서 소외되지 않고 주체적으로 참여하겠다는 강력한 '협상 요구'입니다. 따라서 해결 방안의 목표는 노조를 억누르는 것이 아니라, 이들을 AI 전환의 가장 중요한 '파트너'로 만드는 것이어야 합니다. 해결 방안: 'AI 전환 파트너십' 3자 협약 모델 이 모델은 '사회적 안전망'과 '산업적 가속 페달'의 원리를 특정 산업 현장에 맞게 구체화한 것입니다. 1. 기업의 역할: '이익 공유'와 '재교육 투자'를 통한 신뢰 구축 기업은 AI 로봇 도입으로 얻게 될 막대한 이익을 독점하는 대신, 그 과실을 노동자들과 공유하고 이들의 미래에 투자하는 모습을 보여주어야 합니다. ① 생산성 향상 이익 공유제 도입: * AI 로봇 도입으로 발생하는 비용 절감액과 생산성 향상분의 일정 비율(예: 20%)을 노사 합의로 'AI 전환 기금'으로 적립합니다. 이 기금은 아래의 재교육 및 전환 배치 프로그램의 재원으로 사용됩니다. ② 대규모 사내 재교육 및 '신(新)직무' 전환 배치: * 단순 조립 라인의 노동자를 해고하는 대신, 이들을 새로운 시대에 필요한 인력으로 재교육하여 전환 배치합니다. 이것이 바로 '기여 인센티브' 개념을 기업 내에서 실현하는 것입니다. * '로봇 유지보수 및 운영 전문가': 현장 경험이 풍부한 노동자들이 로봇의 일상적인 점검, 유지보수, 운영을 책임집니다. * 'AI 시스템 모니터링 및 평가자': 로봇의 생산 데이터를 모니터링하고, 로봇의 움직임이나 작업 결과가 비정상적일 때 이를 식별하고 평가하는 역할을 합니다. (예: "이 로봇의 용접 불량률이 높아지고 있다.") * '공정 데이터 라벨러 및 AI 트레이너': 숙련된 인간 노동자의 정교한 움직임과 문제 해결 과정을 데이터로 기록하고, 이를 AI가 학습할 수 있도록 가공(라벨링)합니다. 이는 AI 로봇의 완성도를 높이는 가장 중요한 '데이터 노동'이며, 기존 노동자들에게 새로운 고부가가치 직무를 제공합니다. 2. 노조의 역할: '저항의 주체'에서 '전환의 주체'로 노조는 고용 안정을 보장받는 대신, AI 도입에 협력하며 조합원들이 새로운 시대에 적응하도록 이끄는 역할을 맡습니다. ① 단계적 AI 도입 협력: * 회사가 제안한 '이익 공유' 및 '재교육' 계획을 신뢰하고, AI 로봇 도입 자체에 대한 반대를 철회합니다. 대신, 가장 위험하거나 반복적인 공정부터 로봇을 도입하는 '단계적 계획'을 회사와 함께 수립합니다. ② 재교육 프로그램 공동 설계 및 운영: * 회사가 제공하는 재교육 프로그램이 실효성이 있는지 감시하고, 현장 노동자들의 눈높이에 맞게 커리큘럼을 공동으로 설계하고 운영합니다. ③ '신(新)직무'에 대한 임금 및 단체 협약 체결: * 'AI 트레이너', '로봇 운영 전문가' 등 새롭게 만들어진 직무에 대한 적정한 임금 수준, 노동 조건, 권익 보호를 위한 새로운 단체 협약을 회사와 체결합니다. 노조의 역할이 '기존 일자리 사수'에서 '미래 일자리의 가치 창출 및 권익 보호'로 진화하는 것입니다. 3. 정부의 역할: '안전망' 제공과 '가속 페달' 지원 정부는 이 대타협이 원활하게 이루어지도록, 기업과 노조 양측 모두에게 인센티브를 제공하고 최후의 안전망을 구축합니다. ① 'AI 전환 투자 세제 혜택' 제공 (가속 페달): * 회사가 'AI 전환 기금'에 출연하는 금액과, 노동자 재교육에 투자하는 비용에 대해 파격적인 세액 공제 혜택을 줍니다. 이는 회사가 노동자를 해고하는 대신 재교육을 선택하도록 유도하는 강력한 당근이 됩니다. ② '전환기 고용보험' 적용 (안전망): * 불가피하게 전환 배치되지 못하는 소수의 노동자들을 위해, 일반 실업급여보다 더 긴 기간 동안, 더 높은 수준의 소득을 보장하는 특별 고용보험 프로그램을 적용합니다. 재취업 및 창업 지원도 병행합니다. ③ 국가적 '기본소득/기여 인센티브' 모델의 시범 사업으로 지정: * 이 자동차 공장의 사례를 국가 전체의 사회 시스템 전환을 위한 중요한 시범 사업으로 지정하고, 재교육 참여자나 신직무 종사자에게 국가 차원의 '기여 인센티브'를 추가로 제공하는 방안을 모색합니다. 결론 이러한 3자 파트너십을 통해, 노조의 선언은 더 이상 '위기'가 아닌 '기회'가 됩니다. 기업은 노사 갈등 없이 안정적으로 미래 경쟁력을 확보하고, 노동자들은 일자리를 잃는 대신 새로운 기술 시대의 주역으로 거듭나며, 정부는 사회적 혼란을 최소화하며 산업 구조 전환을 성공적으로 이끌 수 있습니다. 이는 AI 시대의 갈등을 해결하는 가장 현실적이고 상생 가능한 모델이 될 것입니다. 2026 01.28 은행앱 통합하면서 없어졌나보네요. ㄴ 비슷한 기능 찾으시는 분은 : 스마트 금융 계산기 검색해 보세요. https://play.google.com/store/apps/details?id=com.moneta.android.monetacalculator 2026 01.25 Ctrl+Z 를 이용해 뒤로 돌아기기 Undo 기능이 있는지 살펴보세요. 2026 01.23 쌀집계산기로 연립방정식 계산하기 - 크래머/크레이머/크라메르 공식 적용 https://allcalc.org/56739 3. 'x' 값 구하기 계산기 조작법 목표: x = Dx / D = [(c×e) - (b×f)] / [(a×e) - (b×d)] 계산하기 1단계: 분모 D 계산 (메모리 활용) 1 * 1 M+ : 메모리(M)에 1를 더합니다. (현재 M = 1) -0.1 * -0.2 M- : 메모리(M)에서 0.02를 뺍니다. (현재 M = 0.98 = 0.98) 이로써 메모리(MR)에는 분모 0.98가 저장됩니다. 2단계: 분자 Dx 계산 후 나누기 78000 * 1 : 78000를 계산합니다. = : GT에 더합니다. -0.1 * 200000 : -20000를 계산합니다. ± = : 부호를 뒤집어 GT에 넣습니다. // sign changer 버튼 사용 GT : GT를 불러옵니다. GT는 98000 (분자 Dx) 값입니다. ÷ MR = : 위 결과(98000)를 메모리(MR)에 저장된 분모 D(0.98)로 나누어 최종 x값 100,000를 구합니다. 4. 'y' 값 구하기 계산기 조작법 목표: y = Dy / D = [(a×f) - (c×d)] / [(a×e) - (b×d)] 계산하기 1단계: 분모 D 계산 (메모리 활용) 'x'에서와 분모는 동일하고 메모리(MR)에 0.98가 저장되어 있으므로 패스합니다. 2단계: 분자 Dy 계산 후 나누기 GT ± = : GT를 불러오고 부호를 뒤집어 GT에 더합니다. GT가 0으로 리셋됩니다. 【AC】를 누르면 M은 유지되고 GT만 리셋되는 계산기도 있으니 확인해 보세요. 1 * 200000 : 200000를 계산합니다. = : GT에 더합니다. 78000 * -0.2 : -15600를 계산합니다. ± = : 부호를 뒤집어 GT에 넣습니다. GT : GT를 불러옵니다. 215600 (분자 Dy) 값입니다. ÷ MR = : 위 결과(215600)를 메모리(MR)에 저장된 분모 D(0.98)로 나누어 최종 y값 220,000를 구합니다. x, y 값을 이용해 최종 결과를 구합니다. 2026 01.18