- 세상의 모든 계산기 자유(질문) 게시판 일반 ()

알파고에 사용된 것은 GPU 가 아니라 TPU?

출처 : https://cloudplatform.googleblog.com/2016/05/Google-supercharges-machine-learning-tasks-with-custom-chip.html

|

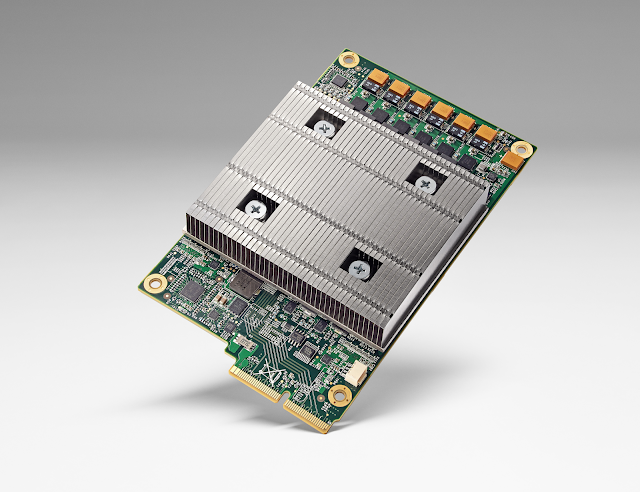

| Tensor Processing Unit board |

|

| Server racks with TPUs used in the AlphaGo matches with Lee Sedol |

- 이세돌과의 대국에서 승리를 확정했던 3국의 기보가 붙어있네요. (4국이었다면 좀 더 인간적?이었을 것 같기도 하고...)

- 기존에 알려졌던 것과 달리, 알파고 AI(Tensorflow) 구현에 있어 GPU(범용 칩)이 아닌 주문형 반도체인 ASIC 칩을 사용한 것 같습니다. (이건 확실치 않습니다)

- 그림상 하나의 M/B 에 4개의 검정 케이블이 바로 TPU와 M/B 를 연결하기 위한 PCIE extension 케이블인 것으로 보입니다.

- 사진상으로는 개별 머쉰이 총 (6*8)-2 = 46 개입니다.

46*4 = 184 인데... 기존에 176개 GPU가 사용되었다고 알려진 것을 생각하면 얼추 맞는 것 같긴 하네요. - 사용된 CPU 갯수도 (기존에 추정되었던 개별 CPU 단위가 아니라) 코어(혹은 쓰레드) 단위일 가능성이 높아 보입니다.

46*12C=552C, 46*24T=1104T. (듀얼이라면, 2208T인데 1920과 얼추 맞는 것 같습니다. 1920=24*2*40)

참고 링크

- http://www.recode.net/2016/5/20/11719392/google-ai-chip-tpu-questions-answers

댓글5

-

세상의모든계산기

월 스트리트 저널 기사 - 링크 : http://www.wsj.com/articles/google-isnt-playing-games-with-new-chip-1463597820 를 읽어보니 GPU 가 이닌 ASIC을 사용한 것이 확실해 보이네요.

When Google’s AlphaGo computer program bested South Korean Go champion Lee Se-dol in March, it took advantage of a secret weapon: a microprocessor chip specially designed by Google.

기사에 따르면 다른 대안(아마도 GPU)보다 전반적으로 10배 빠른 계산이 가능했다는 것 같습니다. (기사에는 MS 도 AI 분야에 FPGA 칩을 사용한다고 합니다. IBM 도 전용 칩을 쓴다고 하구요. 아범이야 뭐 당연한거지만...)

-

세상의모든계산기

구글 직원(Solutions Engineer for Google Cloud Platform at Google. Co-organizer @codemotion_es)의 트윗

https://twitter.com/nachocoloma/status/733169977432395776

이로서 확실해졌네요. GPU 는 사용되지 않았습니다. 대신 더 뛰어난 TPU 가 사용되었습니다.

(당분간!) 범용 PC 구성(CPU+GPU)으로 알파고 수준에 도달하기는 쉽지 않겠습니다. 하물며 CPU 만 사용하는 상용 바둑 프로그램으로는...

-

세상의모든계산기

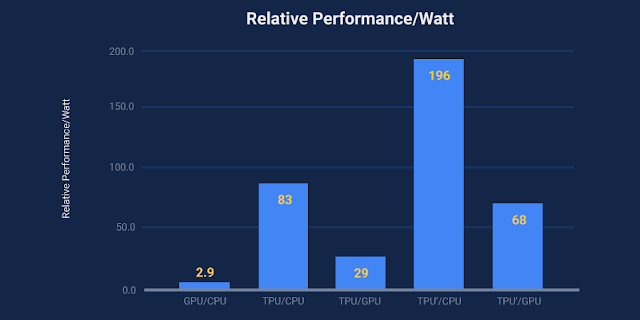

TPU의 전성비

출처 : https://cloudplatform.googleblog.com/2017/04/quantifying-the-performance-of-the-TPU-our-first-machine-learning-chip.html

Quantifying the performance of the TPU, our first machine learning chip

Wednesday, April 5, 2017

By Norm Jouppi, Distinguished Hardware Engineer, Google

(503 에러때문에 못본다면 블로그에서 날짜로 찾아보세요)

세상의모든계산기 님의 최근 댓글

감사합니다. 주말 잘 보내세요. 2026 03.06 [fx-570 ES] 과학 상수를 이용한 계산에서 에러 발생 상황 https://kin.naver.com/qna/detail.naver?d1id=11&dirId=1118&docId=492235162&page=1&answerNo=1 vs 2026 03.01 과학상수를 이용한 계산 중 자릿수 한계로 인한 에러 발생 가능성 https://allcalc.org:443/board_calculators/6925#comment_57029 2026 03.01 기본 어댑터 MODEL : AD0301-1202500GB INPUT : 100~240V, 50~60Hz, 0.8A Max OUTPUT : 12.0V, 2.5A, 30.0W ㄴ 측정시 플러그 외경/내경 : 5.5mm / 2mm 2026 02.15 엑셀 파일로 만드니 전체 160~200MB 정도 나옵니다. 읽고 / 저장하는데 한참 걸리네요. 컴 사양을 좀 탈 것 같습니다. -> 엑셀/한셀에서 읽히지만, 구글 스프레드시트에서는 열리지 않네요. 100만 개 단위로 끊어서 20MB 정도로 분할해 저장하는 편이 오히려 속 편할 것 같습니다. -> 이건 구글 스프레드시트에서도 열리긴 하네요. (약간 버퍼링?이 있습니다) 2026 02.10